La loi de Moore

À propos de ce écoles sélection Wikipedia

SOS Enfants a essayé de rendre le contenu plus accessible Wikipedia par cette sélection des écoles. Cliquez ici pour plus d'informations sur les enfants SOS.

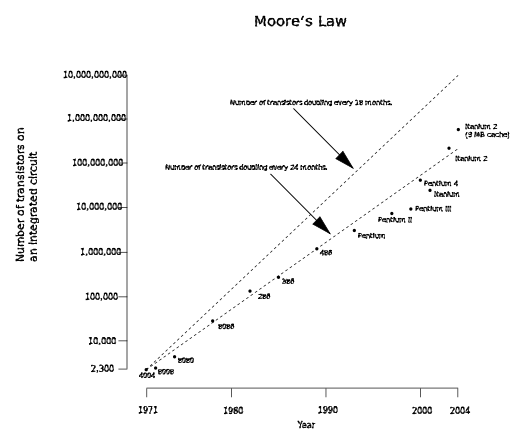

La loi de Moore décrit une tendance importante dans l' histoire de matériel informatique : que le nombre de transistors qui peuvent être placés à peu de frais sur un circuit intégré est en augmentation exponentielle , doublant environ tous les deux ans. L'observation a été faite par Intel co-fondateur Gordon E. Moore dans un document 1965. La tendance se est poursuivie pendant plus d'un demi-siècle et ne est pas prévu de se arrêter pour une autre décennie au moins et peut-être beaucoup plus longtemps.

Presque chaque mesure des capacités des appareils électroniques numériques est lié à la loi de Moore: la vitesse de traitement, la capacité de mémoire, même la résolution des appareils photo numériques. Tous ces éléments sont progressé au (environ) exponentielles taux ainsi. Cela a considérablement augmenté l'utilité de l'électronique numérique dans presque tous les segments de l'économie mondiale. La loi de Moore décrit cette force motrice de l'évolution technologique et sociale de la fin du 20e et au début du 21e siècles.

Histoire

Déclaration originale de Moore que du nombre de transistors a doublé chaque année peut être trouvé dans sa publication "Gavage plus composants sur les circuits intégrés », Electronique magasin 19 Avril, 1965:

| " | La complexité des coûts de composants minimum a augmenté à un rythme d'environ un facteur de deux par an ... Certainement à court terme ce taux peut être devrait se poursuivre, sinon à augmenter. À plus long terme, le taux d'augmentation est un peu plus incertain, bien qu'il n'y ait aucune raison de croire qu'il ne restera presque constante pendant au moins 10 ans. Cela signifie que d'ici 1975, le nombre de composants par circuit intégré pour un coût minimum sera 65,000. Je crois qu'un tel grand circuit peut être construit sur une seule plaquette. | " |

Le terme «loi de Moore» a été inventé vers 1970 par le Professeur Caltech, VLSI pionnier, et entrepreneur Carver Mead. Moore peut-être entendu Douglas Engelbart, un co- inventeur de mécanique aujourd'hui souris d'ordinateur, de discuter de la réduction d'échelle projetée de la taille du circuit intégré dans une conférence de 1960.

En 1975, Moore a changé sa projection à un doublement tous les deux ans. Malgré la croyance populaire, il est catégorique: il ne permet pas de prévoir un doublement "tous les 18 mois." Toutefois, un collègue Intel avait pris en compte l'augmentation des performances des transistors de conclure que les circuits intégrés seraient doubler la performance tous les 18 mois.

En Avril 2005, Intel a offert $ 10 000 pour acheter une copie de l'original Electronics Magazine. David Clark, un ingénieur vivant au Royaume-Uni, a été le premier à trouver une copie et l'offrir à Intel.

D'autres formulations et des lois similaires

Alan Turing a écrit que par le tournant du siècle, nous aurons ordinateurs sur notre bureau avec un milliard de mots de mémoire dans la première partie de son papier uniquement publié - ce était d'environ 15 ans avant l'observation de Moore.

Plusieurs mesures de la technologie numérique se améliorent à un rythme exponentiel liés à la loi de Moore, y compris la taille, le coût, la densité et la vitesse des composants. Notez que Moore lui-même a écrit seulement sur la densité des composants (transistors) ou à un coût minimal. Il a noté:

La loi de Moore a été le nom donné à tout ce qui change de façon exponentielle. Je dis, si Gore a inventé l'Internet, je ai inventé le exponentielle.

Transistors par circuit intégré. La formulation la plus populaire est le doublement du nombre de transistors sur circuits intégrés tous les deux ans. A la fin des années 1970, la loi de Moore est devenu connu comme la limite pour le nombre de transistors sur les puces plus complexes. Les tendances récentes montrent que ce taux a été maintenu en 2007.

Densité à moindre coût par transistor. Ce est la formulation donnée en 1965 papier de Moore. Il ne est pas juste à propos de la densité de transistors qui peuvent être atteints, mais à propos de la densité des transistors à laquelle le coût par transistor est le plus bas. Comme plus de transistors sont mis sur une puce, le coût de faire chaque transistor diminue, mais la chance que la puce ne fonctionne pas en raison d'un défaut augmente. En 1965, Moore a examiné la densité des transistors à laquelle le coût est minimisée, et a observé que, comme des transistors plus petits ont été faites grâce aux progrès photolithographie, ce nombre augmenterait à "un taux d'environ un facteur de deux par an".

Coût par transistor. Comme la taille des transistors a diminué, le coût par transistor a diminué également. Cependant, le coût de fabrication par unité de surface a seulement augmenté au fil du temps, car les matériaux et les dépenses d'énergie par unité de surface ne ont augmenté à chaque noeud de la technologie successive.

Les performances de calcul par unité de coût. En outre, comme la taille des transistors diminue, la vitesse à laquelle elles opèrent augmente. Il est également fréquent de citer la loi de Moore se référer à l'avance de poursuivre rapidement dans le calcul de la performance par coût unitaire, parce augmentation de nombre de transistors est également une mesure approximative des performances de traitement informatique. Sur cette base, les performances des ordinateurs par le coût unitaire ou plus familièrement, «bang par buck" -doubles tous les 24 mois.

La consommation électrique. la consommation d'énergie de noeuds de calcul double tous les 18 mois.

Coût de stockage du disque dur par unité d'information. Une loi similaire (appelé parfois Droit de Kryder) a tenu pour coût de stockage du disque dur par unité d'information. Le taux de progression stockage sur disque au cours des dernières décennies a effectivement accéléré plus d'une fois, correspondant à l'utilisation de codes correcteurs d'erreurs, le et l'effet magnétorésistif effet magnétorésistance géante. Le taux actuel d'augmentation capacité du disque dur est à peu près semblable à celui de l'augmentation de nombre de transistors. Les tendances récentes montrent que ce taux a été maintenu en 2007.

Capacité de stockage RAM. Un autre des états de version que RAM capacité de stockage augmente au même rythme que la puissance de traitement.

La capacité du réseau Selon Gerry / Gerald Butters, l'ancien chef du Groupe de réseautage optique de Lucent au De Bell Labs, il ya une autre version, appelée loi de beurre de photonique, une formulation qui est parallèle délibérément la loi de Moore. La loi de beurre dit que la quantité de données qui sortent d'une fibre optique double tous les neuf mois. Ainsi, le coût de la transmission d'un bit sur un réseau optique diminue de moitié tous les neuf mois. La disponibilité de multiplexage par répartition en longueur d'onde (parfois appelé "WDM") a augmenté la capacité pouvant être placé sur une seule fibre de jusqu'à un facteur de 100. Les réseaux optiques et DWDM apporte rapidement baisser le coût de la mise en réseau, et de nouveaux progrès semble assurée. En conséquence, le prix de gros du trafic de données se est effondré dans le bulle dot-com. Loi de Nielsen dit que la bande passante disponible pour les utilisateurs augmente de 50% chaque année.

Pixels par dollar. De même, Barry Hendy de Kodak Australie a tracé les "pixels par dollar" comme une mesure de base de la valeur pour un appareil photo numérique, ce qui démontre la linéarité historique (sur une échelle logarithmique) de ce marché et la possibilité de prédire l'avenir tendance du prix de l'appareil photo numérique et résolution.

Une prophétie auto-réalisatrice: l'industrie a du mal à suivre la loi de Moore

Bien que la loi de Moore a d'abord été réalisé sous la forme d'un observation et Prévisions, le plus largement accepté il est devenu, plus il a servi comme un objectif pour toute une industrie. Ceci a conduit à la fois marketing et ingénierie départements de semi-conducteurs aux fabricants de concentrer une énergie énorme visant l'augmentation spécifié dans la puissance de traitement qu'il a présumé un ou plusieurs de leurs concurrents serait bientôt fait atteindre. À cet égard, il peut être considéré comme un prophétie auto-réalisatrice. Par exemple, le SEMATECH feuille de route suit un cycle de 24 mois.

Les implications de la loi de Moore pour ordinateur fournisseurs de composants sont très importants. Un projet majeur de conception typique (comme un tout nouveau lecteur de CPU ou disque) prend entre deux et cinq ans pour atteindre le statut de prêt à la production. En conséquence, les fabricants de composants confrontés à d'énormes pressions échelle de temps-quelques semaines de retard dans un projet majeur peut faire la différence entre un grand succès et des pertes massives, même faillite. Exprimé (à tort) comme «un doublement tous les 18 mois", la loi de Moore suggère progrès phénoménal pour la technologie sur la durée de quelques années. Exprimé sur une plus courte calendrier, cependant, cela équivaut à une amélioration de la performance moyenne de l'industrie dans son ensemble de près de 1% par semaine. Ainsi, pour un fabricant sur le marché du CPU concurrentiel, un nouveau produit qui devrait prendre trois ans pour développer et se avère que trois ou quatre mois de retard est de 10 à 15% plus lent, plus volumineux, ou moins de capacité que les produits directement concurrents , et est proche de invendables. Si nous acceptons la place que la performance va doubler tous les 24 mois, plutôt que tous les 18 ans, un délai de trois à quatre mois se traduirait à la performance 8-11% inférieur.

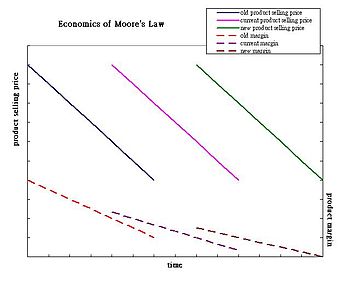

Comme le coût de l'énergie à l'ordinateur consommation chute, le coût pour les producteurs de se acquitter de la loi de Moore suit une tendance inverse: R & D, la fabrication et les coûts de test ont augmenté de façon constante à chaque nouvelle génération de puces. Le coût de fabrication par unité de surface augmente, mais l'aire occupée par le produit final ne diminue généralement pas. Fabricants de circuits intégrés ont généralement compté sur rétrécissement transistors pour améliorer les performances en complétant la même zone de la puce avec plus de transistors. Cela a été le meilleur exemple récemment par le doublement simultanée du nombre de cœurs dans un processeur tandis que la taille réduite de moitié environ a matrice.

Comme on prévoit que le coût de l'équipement de semi-conducteurs de continuer à augmenter, les fabricants doivent vendre des quantités de puces plus en plus grandes pour rester rentables. (Le coût pour bande sur une puce à 180 nm était d'environ US $ 300 000. Le coût pour la bande-out une puce à 90 nm US dépasse $ 750 000, et devrait dépasser US $ 1.000.000 pour 65 nm) Malgré l'augmentation des coûts, le prix de détail du produit final ne peut pas se attendre à augmenter.; généralement, ils ont tendance à rester dans la même gamme de prix. En conséquence, les marges des produits devraient suivre une tendance à la baisse. Au cours des dernières années, les analystes ont observé une baisse du nombre de mises en chantier "design" au niveau des nœuds de processus avancés (130 nm et au-dessous de 2007). Bien que ces observations ont été faites dans la période après la crise économique de 2000, le déclin peut être une preuve que les fabricants traditionnels à long terme marché mondial ne peut pas soutenir économiquement la loi de Moore.

Les tendances futures

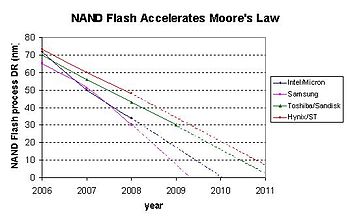

technologie «feuilles de route de l'industrie de l'ordinateur 'prédisent (en 2001) que la loi de Moore se poursuivra pendant plusieurs générations de puces. Selon le temps de doublement utilisée dans les calculs, cela pourrait signifier une augmentation de jusqu'à cent fois dans le transistor comptage par puce dans une décennie. La feuille de route de la technologie de l'industrie des semiconducteurs utilise un temps de doublement de trois ans pour microprocesseurs, conduisant à une augmentation de dix fois dans la prochaine décennie. Intel a été signalé en 2005 comme indiquant que la réduction des effectifs de silicium des puces avec une bonne économie peut se poursuivre au cours de la prochaine décennie et en 2008, que de prévoir la tendance grâce à 2029. En fait, la loi de Moore a accéléré dans le cas de la NAND La mémoire flash, qui est utilisée pour le stockage dans les appareils photo numériques, les lecteurs flash, lecteurs MP3, et plus récemment, les disques SSD (SSD).

Certaines des nouvelles orientations de la recherche qui peuvent permettre la loi de Moore continue sont:

- La prédiction d'Intel de l'utilisation croissante de matériaux autres que le silicium a été vérifiée à la mi-2006, comme ce était son intention d'utiliser transistors trigate du monde 2009.

- Des chercheurs de l' IBM et Georgia Tech a créé un nouveau record de vitesse quand ils ont couru un silicium / germanium hélium surfusion transistor à 500 gigahertz (GHz). Le transistor fonctionne au-dessus de 500 GHz à 4,5 K (-451 ° F / -268,65 ° C) et les simulations ont montré qu'il pourrait probablement fonctionner à 1 THz (1,000 GHz). Ce procès ne testé un seul transistor, cependant. CPU de bureau pratiques fonctionnant à cette vitesse sont extrêmement peu probable en utilisant des techniques de puces de silicium contemporaine.

- Au début de 2006, IBM chercheurs ont annoncé qu'ils avaient développé une technique pour imprimer des circuits seulement 29,9 nm de large en utilisant profonde ultraviolet (DUV, 193 nanomètres) lithographie optique. IBM affirme que cette technique peut permettre fabricants de puces à utiliser des méthodes actuelles pendant sept ans tout en continuant à obtenir des résultats prévus par la loi de Moore. De nouvelles méthodes permettant d'atteindre plus petits circuits devraient être sensiblement plus coûteuses.

- Sur 27 janvier 2007 , Intel a démontré un travail puce 45nm nom de code " Penryn ", avec l'intention de commencer la production de masse à la fin de 2007. Une décennie auparavant, jetons ont été construits en utilisant un procédé 350 nm.

- Entreprises travaillent sur l'utilisation nanotechnologies pour résoudre les problèmes d'ingénierie complexes impliqués dans la fabrication de puces au 32 nm et plus petits niveaux. (Le diamètre d'un atome de silicium est de l'ordre de 0,2 nm).

- En Avril 2008, les chercheurs de HP Labs ont annoncé la création d'un travail " memristor ":.. un quatrième élément de circuit passif de base dont l'existence avait été auparavant seulement théorisé propriétés uniques du memristor permettent la création de petits et plus performants les appareils électroniques Ce memristor une certaine ressemblance avec mémoire résistive ( CBRAM ou RRAM) développée indépendamment et récemment par d'autres groupes pour des applications de mémoire non volatile.

Bien que cet horizon de temps pour la mise à l'échelle loi de Moore est possible, il ne est pas sans défis d'ingénierie sous-jacente. L'un des principaux défis dans les circuits intégrés qui utilisent transistors nanométriques est en augmentation variation paramètre et les courants de fuite. En raison de la variation et de fuite, la marges de conception disponibles pour faire la conception prédictive sont de plus en plus difficile. Ces systèmes se dissipent aussi un pouvoir considérable, même lorsqu'il ne est pas de commutation. Adaptative et statistiques conception avec réduction de puissance fuite est essentielle pour soutenir l'échelle de CMOS. Un bon traitement de ces sujets est couvert dans Fuite dans nanométriques CMOS Technologies. Autres défis d'échelle comprennent:

- La capacité de contrôle de la résistance et de la capacité parasite dans les transistors,

- La possibilité de réduire la résistance et la capacitance électrique dans interconnexions,

- La capacité de maintenir transistor bon électrostatique afin de permettre la borne de grille pour contrôler le comportement ON / OFF,

- L'augmentation de l'effet de la ligne rugosité de bord,

- Dopant fluctuations,

- livraison de puissance au niveau du système,

- Conception thermique à gérer efficacement la dissipation de puissance délivrée, et

- Résoudre tous ces défis à un toujours réduire les coûts de fabrication de l'ensemble du système.

Limites ultimes de la loi

En 1995, le "puissant" Puce DEC Alpha (acquis par Compaq, et maintenant partie de Hewlett-Packard) était composée d'environ neuf millions de transistors. Ce processeur 64 bits est un fer de lance technologique à l'époque, même si la part de marché de le circuit est resté moyenne. Six ans plus tard, un état du microprocesseur de l'art aurait plus de 40 millions de transistors. En 2015, on estime que ces processeurs devraient contenir plus de 15 milliards de transistors. Les choses deviennent plus petits chaque année. Si cela continue, en théorie, en moins de 10 ans ordinateurs seront créés où chaque molécule aura sa place, ce est à dire que nous aurons complètement entré dans l'ère de la production à l'échelle moléculaire.

Sur 13 avril 2005 , Gordon Moore lui-même déclaré dans une interview que la loi ne peut pas être maintenue indéfiniment: ". Il ne peut pas continuer éternellement La nature des exponentielles, ce est que vous poussez-les et éventuellement catastrophe ne se produise" et a noté que transistors finirait par atteindre les limites de la miniaturisation au niveaux atomiques:

| " | En termes de taille [du transistor] vous pouvez voir que nous nous approchons de la taille des atomes qui est un obstacle fondamental, mais il serez deux ou trois générations avant d'en arriver là, mais ce est aussi loin que nous avons jamais pu voir. Nous avons encore 10 à 20 ans avant d'atteindre une limite fondamentale. D'ici là, ils seront en mesure de faire de plus grands jetons et des budgets de transistors dans les milliards. | " |

Lawrence Krauss et Glenn D. Starkman a annoncé une limite ultime d'environ 600 années dans leur article «Limites universelles de calcul", basé sur une estimation rigoureuse de la capacité totale de traitement des informations de tout système dans le Univers .

Là encore, la loi a souvent rencontré des obstacles qui semblaient insurmontables, avant dès les surmonter. En ce sens, Moore dit qu'il voit désormais sa loi comme plus belle que ce qu'il avait réalisé: «La loi de Moore est une violation de La loi de Murphy. Tout va de mieux en mieux. "

Il est possible que finalement l'informatique quantique peut permettre de dépasser l'informatique les restrictions atomiques de taille de niveau, mais cela ne semble pas à portée de main dans un avenir prévisible.

Futuristes et la loi de Moore

Extrapolation basée en partie sur la loi de Moore a conduit futuristes tels que Vernor Vinge, Bruce Sterling, et Ray Kurzweil de spéculer sur un singularité technologique. Projets Kurzweil que le maintien de la loi de Moore jusqu'en 2019 se traduira par transistor dispose de seulement quelques atomes de largeur. Bien que cela signifie que la stratégie de plus en plus fin photolithographie aura son cours, il spécule que cela ne signifie pas la fin de la loi de Moore:

| " | La loi de Moore de circuits intégrés ne était pas la première, mais la cinquième paradigme devrait accélérer ratios prix-performance. dispositifs informatiques ont été constamment multiplient au pouvoir (par unité de temps) des dispositifs de calcul mécaniques utilisés dans le 1890 US Census, à [ ] Sur la base de relais de Newman " [Heath] Robinson "machine qui craqué le nazie [ Machine de Lorenz], à la CBS ordinateur de tube à vide qui prédisait l'élection de Eisenhower , aux machines à transistors utilisés dans le premier lancements spatiaux, à l'ordinateur personnel basé à circuit intégré. | " |

Ainsi, Kurzweil conjecture qu'il est probable que certains nouveau type de technologie remplacera la technologie de circuit intégré en cours, et que la loi de Moore sera vrai longtemps après 2020. Il croit que la croissance exponentielle de la loi de Moore continuera au-delà de l'utilisation de circuits intégrés dans les technologies qui mèneront à la singularité technologique. Le Loi du retour accéléré décrits par Ray Kurzweil a de nombreuses façons modifié la perception du public de la loi de Moore. Ce est une croyance commune (mais erronée) que la loi de Moore fait des prédictions concernant toutes les formes de la technologie, quand il fait ne concerne semi-conducteurs circuits. Beaucoup futuristes utilisent encore le terme «loi de Moore» dans ce sens plus large pour décrire des idées comme celles mises en avant par Kurzweil.

Logiciel: enfreindre la loi

Un point parfois mal compris, ce est que de façon exponentielle améliorée matériel ne impliquent nécessairement de façon exponentielle améliorée les performances du logiciel pour aller avec elle. La productivité des développeurs de logiciels assurément ne augmente pas de façon exponentielle avec l'amélioration de matériel, mais par la plupart des mesures n'a augmenté que lentement et de façon intermittente au cours des décennies. Logiciel tend à devenir de plus en plus compliqué au fil du temps, et Loi de Wirth déclare même avec humour que «Software devient plus lent plus rapide que le matériel devient plus rapide".

Il ya des problèmes où l'augmentation exponentielle de la puissance de traitement sont jumelés ou dépassé par une augmentation exponentielle de la complexité que la taille problème augmente. (Voir théorie de la complexité de calcul et classes de complexité P et NP pour une analyse quelque peu théorique de ces problèmes, qui se produisent très fréquemment dans les applications telles que ordonnancement.)

Grâce à la puissance mathématique de croissance exponentielle (similaire à la puissance financière de l'intérêt composé), les fluctuations apparemment mineures dans les taux de croissance relatifs des performances du processeur, capacité de mémoire vive et d'espace disque par dollar ont causé les coûts relatifs de ces trois ressources informatiques fondamentales de passer nettement au fil des ans, qui à son tour a causé d'importants changements dans les styles de programmation. Pour de nombreux problèmes de programmation, le développeur doit décider sur de nombreux compromis l'espace-temps, et tout au long de l'histoire du calcul de ces choix ont été fortement influencés par les coûts relatifs changeants de cycles CPU par rapport à l'espace de stockage.

En plus de processeur utilisation / stockage espace compromis, il ya souvent une corrélation entre le temps de développement, la complexité de l'application, et les performances de l'application. Un exemple de ceci serait l'algorithme de tri trier insertion par rapport à la algorithme de tri rapide. Même si un tri par insertion est l'un des algorithmes plus simple et moins complexe tri pour mettre en œuvre, il est aussi quelque peu lent pour un grand nombre de données. Comme les performances du processeur augmente, les programmeurs peuvent décider de mettre en œuvre des algorithmes plus lents et moins complexes en faveur d'un temps de développement plus court.

Autres considérations

Pas tous les aspects de la technologie informatique à développer des capacités et la vitesse en fonction de la loi de Moore. Aléatoire mémoire (RAM) et des vitesses disque dur améliorer les temps de recherche, au mieux quelques points de pourcentage chaque année. Comme la capacité de RAM et des disques durs augmente beaucoup plus rapidement que ce est leur vitesse d'accès, l'utilisation intelligente de leur capacité devient de plus en plus important. Il est maintenant logique dans de nombreux cas à l'espace commercial pour le temps, par exemple en pré-calculer les index et les stocker dans des moyens qui facilitent l'accès rapide, au détriment de l'utilisation de plus d'espace disque et de mémoire: l'espace est moins en moins cher par rapport au temps.

En outre, il existe une croyance populaire que la vitesse d'horloge d'un processeur détermine sa vitesse, également connu sous le nom Mythe mégahertz. Cela en fait dépend également du nombre d'instructions par les tiques qui peuvent être exécutées (ainsi que la complexité de chaque instruction, voir MIPS, RISC et CISC), et ainsi la vitesse d'horloge ne peut être utilisé pour la comparaison entre les deux circuits identiques. Bien sûr, d'autres facteurs doivent être pris en considération comme la largeur de bus et la vitesse de la périphériques. Par conséquent, les évaluations les plus populaires de "vitesse de l'ordinateur" sont intrinsèquement biaisée, sans une compréhension de la technologie sous-jacente. Ce était particulièrement vrai au cours de la Ère Pentium lorsque les fabricants populaires joués avec les perceptions du public de la vitesse, en se concentrant sur la publicité le taux de nouveaux produits d'horloge.

Une autre idée fausse populaire circulant la loi de Moore est l'hypothèse erronée que le processeur croissance exponentielle de transistor, comme prédit par Moore, se traduit directement en énergie ou le traitement augmentation de la vitesse de traitement exponentielle proportionnelle. Bien que l'augmentation de transistors dans les processeurs ont généralement un effet accru sur la puissance ou la vitesse de traitement, la relation entre les deux facteurs ne est pas proportionnelle. Il ya des cas où une augmentation de ~ 45% dans les transistors des processeurs ont traduits à environ 10 à 20% d'augmentation de la puissance de traitement ou de la vitesse. Différentes familles de processeurs ont performance différents augmente lorsque nombre de transistors est augmentée. Plus précisément, les performances du processeur ou de la puissance est plus liée à d'autres facteurs tels que microarchitecture, et la vitesse d'horloge de la même famille de processeur. Ce est-à-dire les performances du processeur peut augmenter sans augmenter le nombre de transistors dans un processeur. ( processeurs AMD64 ont une meilleure performance globale par rapport à la fin du Pentium 4 série, qui avait plus de transistors).

Il est également important de noter que densité de transistor à multi-core CPU ne reflète pas nécessairement une augmentation similaire de puissance de calcul pratique, en raison de la unparallelised nature de la plupart des applications.